导读:2022年是智能驾驶由L2向L3/L4跨越的窗口期,越来越多的汽车厂商开始布局更高级别的智能驾驶量产,汽车智能化时代已悄然而至。

随着激光雷达硬件的技术提升,车规级量产和成本下行,高级别智能驾驶功能促进了激光雷达在乘用车领域的量产上车,多款搭载激光雷达的车型将在今年交付,2022年也被称为“激光雷达上车元年”。

一、激光雷达传感器vs图像传感器

激光雷达是一种用于精准获取物体三维位置的传感器,本质上是激光探测和测距。凭借在目标轮廓测量、通用障碍物检出等方面所具有的极佳性能,正在成为L4自动驾驶的核心配置。

然而,激光雷达的测距范围(一般在200米左右,不同厂商的量产型号指标各异)导致感知范围远小于图像传感器。

又由于其角分辨率(一般为0.1°或0.2°)比较小,导致点云的分辨率远小于图像传感器,在远距离感知时,投射到目标物上的点可能及其稀疏,甚至无法成像。对于点云目标检测来说,算法真正能用的点云有效距离大约只有100米左右。

图像传感器能以高帧率、高分辨率获取周围复杂信息,且价格便宜,可以部署多个不同FOV和分辨率的传感器,用于不同距离和范围的视觉感知,分辨率可以达到2K-4K。

但图像传感器是一种被动式传感器,深度感知不足,测距精度差,特别是在恶劣环境下完成感知任务的难度会大幅提升。

在面对强光、夜晚低照度、雨雪雾等天气和光线环境,智能驾驶对传感器的算法要求很高。激光雷达虽然对环境光线影响不敏感,但对于积水路面、玻璃墙面等,测距将收到很大影响。

可以看出,激光雷达和图像传感器各有优劣。大多数高级别智能驾驶乘用车选择将不同传感器进行融合使用,优势互补、冗余融合。

这样的融合感知方案也成为了高级别自动驾驶的关键技术之一。

二、基于深度学习的点云和图像融合感知

点云和图像的融合属于多传感器融合(Multi-Sensor Fusion,MSF)的技术领域,有传统的随机方法和深度学习方法,按照融合系统中信息处理的抽象程度,主要分为三个层次:

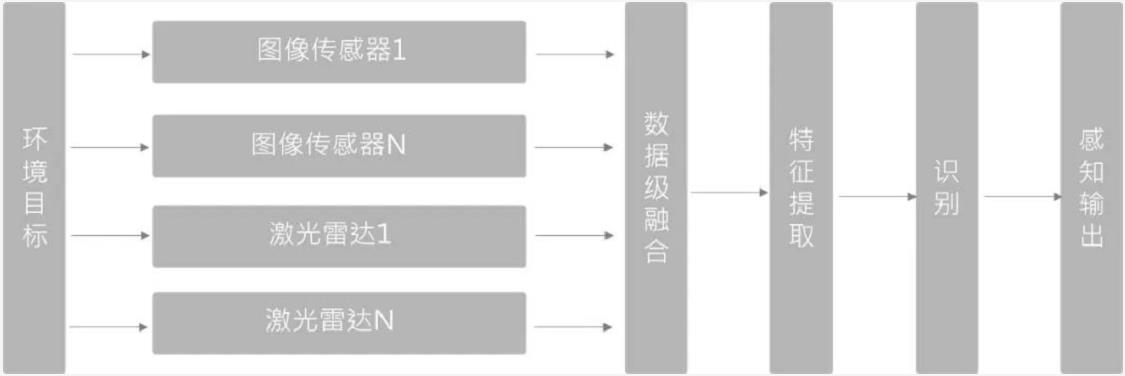

1、数据层融合(Early Fusion)

首先将传感器的观测数据融合,然后从融合的数据中提取特征进行识别。在3D目标检测中,PointPainting(CVPR20)采用这种方式,PointPainting方法先是对图像做语义分割,并将分割后的特征通过点到图像像素的矩阵映射到点云上,然后将这个“绘制点”的点云送到3D点云的检测器对目标Box进行回归。

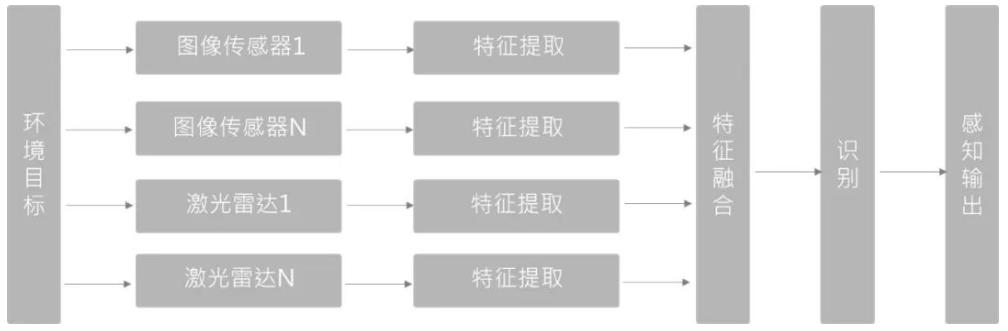

2、特征层融合(Deep Fusion)

先从每种传感器提供的观测数据中提取各自然数据特征,对这些特征融合后进行识别。在基于深度学习的融合方法中,这种方式对点云和图像分支都各自采用特征提取器,对图像分支和点云分支的网络在前反馈的层次中逐语义级别融合,做到多尺度信息的语义融合。

基于深度学习的特征层融合方法,对于多个传感器之间的时空同步要求很高,一旦同步不好,直接影响特征融合的效果。同时,由于尺度和视角的差异,LiDAR和图像的特征融合很难达到1+1>2的效果。

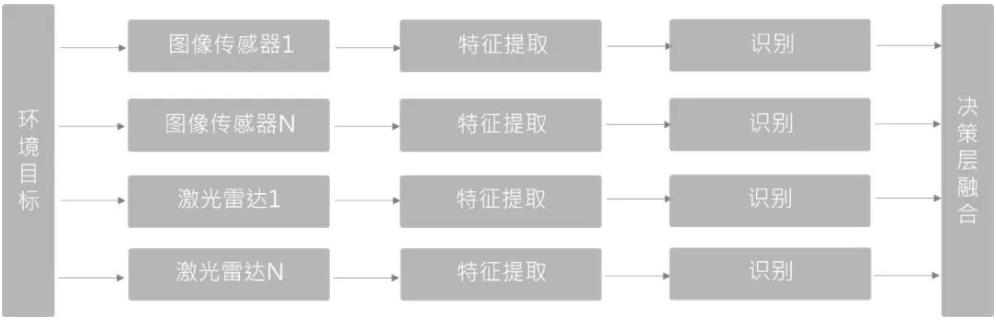

3、决策层融合(Late Fusion)

相对前两种来说,是复杂度最低的一种融合方式。不在数据层或特征层融合,是一种目标级别的融合,不同传感器网络结构互不影响,可以独立训练和组合。

由于决策层融合的两类传感器和检测器相互独立,一旦某传感器发生故障,仍可进行传感器冗余处理,工程上鲁棒性更好。

随着激光雷达与视觉融合感知技术的不断迭代,以及不断积累的知识场景与案例,会出现越来越多的全栈融合计算解决方案为自动驾驶带来更加安全与可靠的未来。

来源:觉非科技JueFX